E1/F1/F4の時代にはVTX周波数でLEDの色を連動させることが出来て楽だったのですが、4波ではそれが出来なくなる可能性があります。

VTX周波数によるLEDの色の決定はレースバンドのチャネルを基準にした周波数で範囲が決めうちになっています。このため4波でレースを行う場合、チャネルの組み合わせによってはVTX連動が出来たり出来なかったりします。

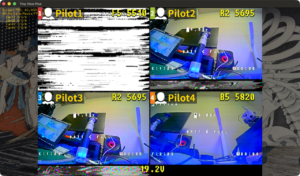

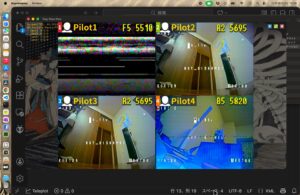

Naka Drone Racing 2026の場合、使用を予定しているチャネルは、E2/E1/F3/F5です、LEDの色はそれぞれ赤/緑/青/黄です。

この組み合わせでVTX連動を使おうとするとE2とE1が同じLED色になってしまいます。VTX連動は完全には使えないわけですが、考えてみるとE2だけ手動でE1/F3/F5は自動で変更することも可能です。

最初は操作性や設定がネックだと思っていたのですが、LED Strip ProfileをRaceモードにした場合でRACE COLORをBLACKにするとVTX連動になることが分かりました。これで操作性もかなり良くなると予測し実験を行いました。

OSD menuにて変更すべきところが一箇所なのでまあまあ使い勝手は良いと思います。動画の通りですが、使用するチャネルがE1/F3/F5の時はRace ColorをBLACKのまま、E2の時はREDにするという運用を行います。万が一従来のE1/F1/F4にフォールバックした場合はF4の時だけBLUEに設定するようにします。

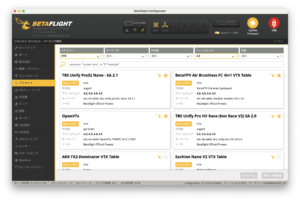

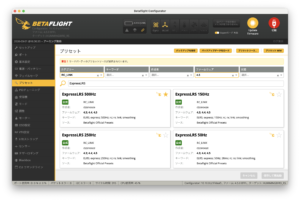

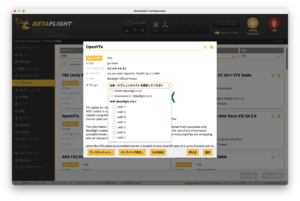

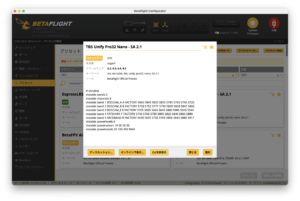

ということで設定を紹介します。

[ Betaflighの設定 ]

例によってCLIの紹介です。

# feature

feature LED_STRIP

# led

led 0 0,0::CT:14

led 1 1,0::CT:14

led 2 2,0::CT:14

led 3 3,0::CT:14

led 4 4,0::CT:14

led 5 5,0::CT:14

led 6 6,0::CT:14

led 7 7,0::CT:14

led 8 8,0::CT:14

led 9 9,0::CT:14

led 10 10,0::CT:14

led 11 11,0::CT:14

led 12 12,0::CT:14

led 13 13,0::CT:14

led 14 14,0::CT:14

led 15 15,0::CT:14

led 16 0,1::CT:14

led 17 1,1::CT:14

led 18 2,1::CT:14

led 19 3,1::CT:14

led 20 4,1::CT:14

led 21 5,1::CT:14

led 22 6,1::CT:14

led 23 7,1::CT:14

led 24 8,1::CT:14

led 25 9,1::CT:14

led 26 10,1::CT:14

led 27 11,1::CT:14

led 28 12,1::CT:14

led 29 13,1::CT:14

led 30 14,1::CT:14

led 31 15,1::CT:14

led 32 0,2::CT:14

led 33 1,2::CT:14

led 34 2,2::CT:14

led 35 3,2::CT:14

led 36 4,2::CT:14

led 37 5,2::CT:14

led 38 6,2::CT:14

led 39 7,2::CT:14

led 40 8,2::CT:14

led 41 9,2::CT:14

led 42 10,2::CT:14

led 43 11,2::CT:14

led 44 12,2::CT:14

led 45 13,2::CT:14

led 46 14,2::CT:14

led 47 15,2::CT:14

led 48 0,3::CT:14

led 49 1,3::CT:14

led 50 2,3::CT:14

led 51 3,3::CT:14

led 52 4,3::CT:14

led 53 5,3::CT:14

led 54 6,3::CT:14

led 55 7,3::CT:14

led 56 8,3::CT:14

led 57 9,3::CT:14

led 58 10,3::CT:14

led 59 11,3::CT:14

led 60 12,3::CT:14

led 61 13,3::CT:14

led 62 14,3::CT:14

led 63 15,3::CT:14

# color

color 2 120,0,255

color 4 240,0,255

color 6 60,0,255

set ledstrip_profile = RACE

set ledstrip_race_color = BLACK

save

この設定の中で、

color 2 120,0,255

color 4 240,0,255

color 6 60,0,255

この部分がレギュレーションによって変わります。今後、使用する4波が決まっていないので決めうちの設定を提供できません。当面の間は四国で行われるレースについてはその都度設定方法を紹介していこうと思います。